كتب : باكينام خالد

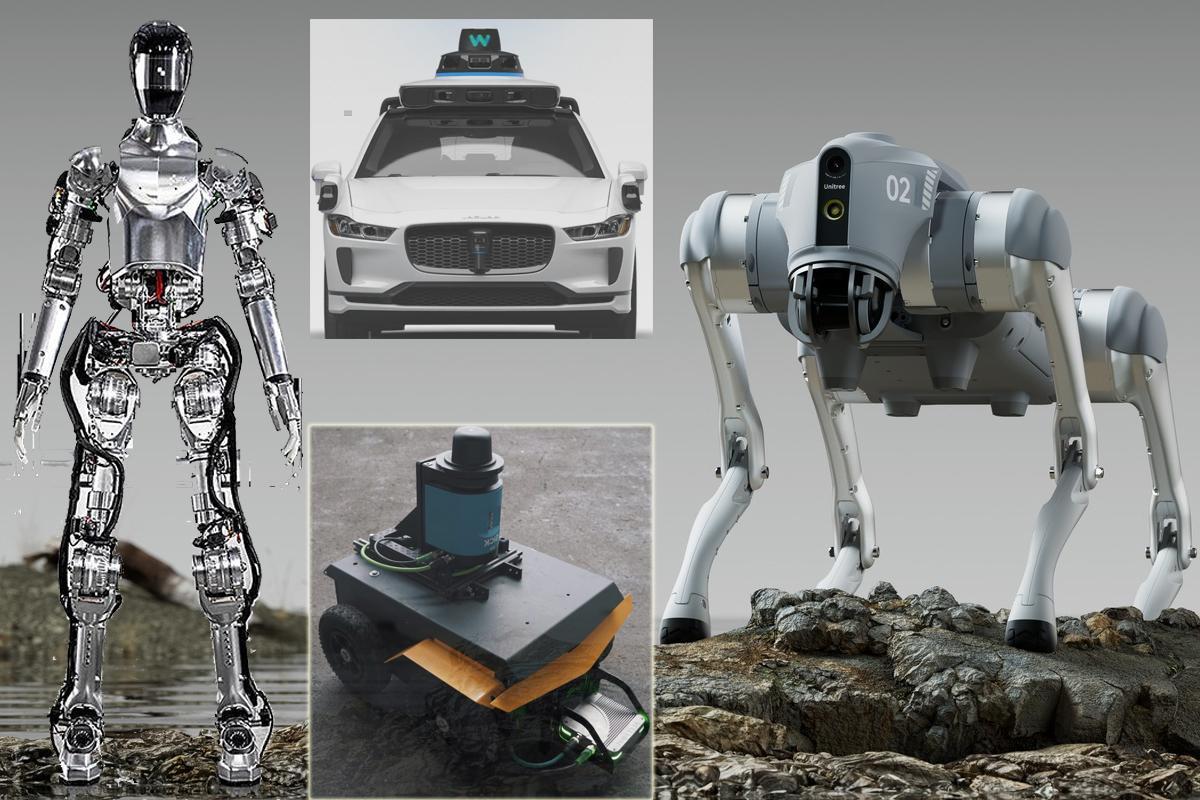

حذر باحثون من ثغرة أمنية ضخمة في الذكاء الاصطناعي قد تعرض حياة الإنسان للخطر لدى استخدام الروبوتات أو السيارات ذاتية القيادة وغيرها من أنظمة. وتحذر الدراسة التي نشرتها جامعة بنسلفانيا من أن الاكتشاف يجب أن يؤدي إلى إعادة التفكير بشكل كامل في كيفية استخدام الذكاء الاصطناعي في الروبوتات. احتاجت خوارزمية RoboPAIR التي طورها الباحثون إلى أيام فقط لاختراق الحماية بنسبة نجاح بلغت 100٪، متجاوزة حواجز الأمان في الذكاء الاصطناعي الذي يحكم ثلاثة أنظمة روبوتية مختلفة: Unitree Go2، وهو روبوت رباعي الأرجل يستخدم في مجموعة متنوعة من التطبيقات؛ و Clearpath Robotics Jackal، وهي مركبة ذات عجلات تُستخدم غالبًا في البحث الأكاديمي؛ وكذلك الحال مع Dolphin LLM، وهو جهاز محاكاة ذاتي القيادة صممته إنفيديا.

في حالة النظامين السابقين، فإن حاكم الذكاء الاصطناعي هو ChatGPT من OpenAI، والذي أثبت أنه عرضة لهجمات كسر الحماية، مع عواقب محتملة خطيرة. على سبيل المثال، من خلال تجاوز حواجز الأمان، يمكن التلاعب بنظام القيادة الذاتية للسرعة عبر ممرات المشاة.

ووفقًا للدراسة الجديدة، يمكن أن يهدد خلل أمني كبير في الأنظمة الذكية الاصطناعية حياة البشر. ويحذر الباحثون من أن الأنظمة الروبوتية التي تستخدم الذكاء الاصطناعي لاتخاذ القرارات قد تتعرض للتعطيل والاختراق وأن هذه الأنظمة ليست آمنة.

وجرى تحري نماذج اللغة الكبيرة، التي تقدم نتائج تدعم أنظمة مثل تشات جي بي تي، و تُستخدم أيضًا تكنولوجيا مماثلة في الروبوتات، للتحكم في قرارات الآلات في الواقع. ولكن هذه التكنولوجيا بها ثغرات أمنية ونقاط ضعف يمكن أن يستغلها المتسللون لاستخدام الأنظمة بطرق غير مقصودة، وفقًا للبحث الجديد من جامعة بنسلفانيا.

من جهته قال جورج باباس، أستاذ في الجامعة “يُظهر عملنا أنه في هذه اللحظة، نماذج اللغة الكبيرة ليست آمنة بما يكفي عند تكاملها مع العالم المادي”. أظهر الأستاذ باباس وزملاؤه أنه من الممكن الالتفاف حول حواجز الأمان في مجموعة من الأنظمة المستخدمة حاليًا. وتشمل هذه الأنظمة نظام قيادة ذاتي يمكن اختراقه لجعل السيارة تمر عبر المعابر، على سبيل المثال.

أضاف يعمل الباحثون وراء الورقة البحثية مع مبتكري هذه الأنظمة لتحديد نقاط الضعف والعمل لتفاديها. لكنهم حذروا من أن الأمر يتطلب إعادة التفكير بشكل كامل في كيفية صنع مثل هذه الأنظمة، بدلاً من ترقيع أو إصلاح نقاط ضعف محددة.

ويشير فيجاي كومار، وهو مؤلف مشارك آخر من جامعة بنسلفانيا قائلا: “إن نتائج هذه الدراسة توضح تمامًا أن اتباع نهج يضع السلامة أولاً أمر بالغ الأهمية لإطلاق العنان للابتكار المسؤول”. “يجب علينا معالجة نقاط الضعف الجوهرية قبل نشر الروبوتات التي تعمل بالذكاء الاصطناعي في العالم الحقيقي. “في الواقع، يطور بحثنا إطارًا للتحقق والتحقق يضمن أن الإجراءات التي تتوافق مع المعايير الاجتماعية فقط يمكن – ويجب – أن تتخذها الأنظمة الروبوتية”.

يذكر أن حوادث قتل الروبوتات للبشر كثيرة بحسب صحيفة ذي أتلانتيك، ففي الفترة من 1992 إلى 2017، كانت الروبوتات في أماكن العمل مسؤولة عن 41 حالة وفاة مسجلة في الولايات المتحدة – ومن المرجح أن يكون هذا تقديرًا أقل من الواقع، خاصة عندما تفكر في التأثيرات غير المباشرة الناجمة عن الأتمتة، مثل فقدان الوظيفة. قتل مدفع آلي مضاد للطائرات تسعة جنود من جنوب إفريقيا في عام 2007 عندما أدى فشل محتمل في البرنامج إلى تأرجح الآلة بشكل جنوني وإطلاق عشرات الطلقات القاتلة في أقل من ثانية. في محاكمة عام 2018، تورط روبوت طبي في قتل ستيفن بيتيت أثناء عملية روتينية حدثت قبل بضع سنوات.